目录 前言 工作原理 代码 前言 工作中偶尔会遇到文件去重的事情,收到一大堆文件,名称各不相同,分析文件的时候发现有不少重复的文件,导致工作效率低下,那么,这里就写了一

目录

- 前言

- 工作原理

- 代码

前言

工作中偶尔会遇到文件去重的事情,收到一大堆文件,名称各不相同,分析文件的时候发现有不少重复的文件,导致工作效率低下,那么,这里就写了一个python脚本实现文件去重功能

工作原理

脚本会检查你给出的文件路径下的所有文件,然后计算每个文件的MD5值,并将其加入到一个列表中。

- 如果某文件的MD5值不在列表中,就认定其是我们需要的文件,脚本会在桌面新建一个名为“去重结果”的文件夹,并将其复制到里面去。

- 如果某文件的MD5值在列表中,就认定其不是我们需要的文件,不对其做任何处理。

- 代码可以直接运行,无需做任何修改(除了安装可能缺少的库文件)

代码

import os

import shutil

import hashlib

# 对文件去重

# 计算每个文件的md5值,据此进行去重

def only_one(test_path):

md5_list = []

count = 0

for current_folder, list_folders, files in os.walk(test_path):

for file in files:

file_path = current_folder + '\\' + file # 获取每个文件的路径

f = open(file_path, 'rb') # 开始计算每个文件的md5值

md5obj = hashlib.md5()

md5obj.update(f.read())

get_hash = md5obj.hexdigest()

f.close()

md5_value = str(get_hash).upper()

# 开始去重

if md5_value in md5_list: # 如果这个文件的md5值曾经出现过,就不对它做任何处理

count += 1

print('\033[31m[-] 发现重复文件:\033[0m' + str(file))

else:

md5_list.append(md5_value) # 如果这个文件的md5值不存在列表中,就添加进列表中

shutil.copy(file_path, path1)

print('\033[31m[-] 共发现重复文件:{}个\033[0m'.format(count))

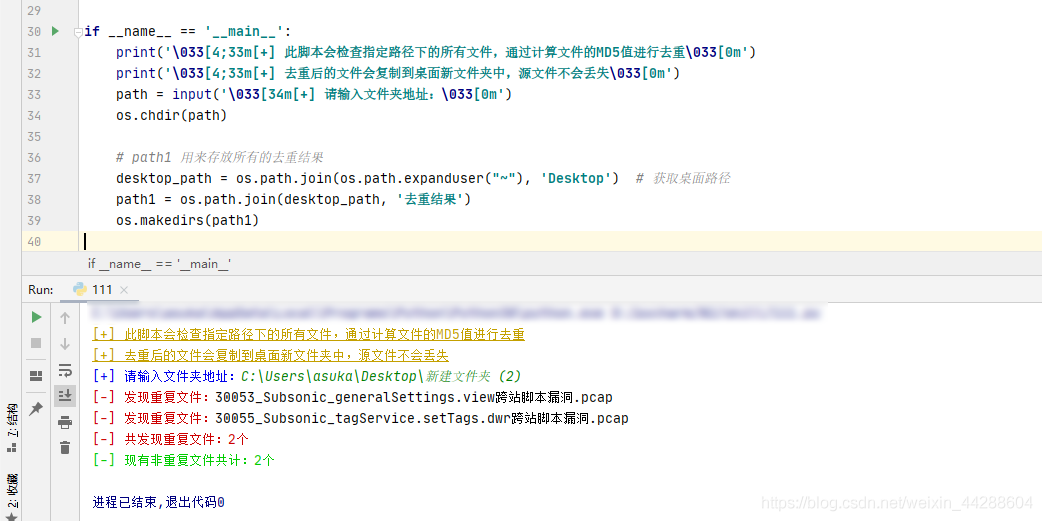

if __name__ == '__main__':

print('\033[4;33m[+] 此脚本会检查指定路径下的所有文件,通过计算文件的MD5值进行去重\033[0m')

print('\033[4;33m[+] 去重后的文件会复制到桌面新文件夹中,源文件不会丢失\033[0m')

path = input('\033[34m[+] 请输入文件夹地址:\033[0m')

os.chdir(path)

# path1 用来存放所有的去重结果

desktop_path = os.path.join(os.path.expanduser("~"), 'Desktop') # 获取桌面路径

path1 = os.path.join(desktop_path, '去重结果')

os.makedirs(path1)

only_one(path)

print('\033[32m[-] 现有非重复文件共计:{}个\033[0m'.format(len(os.listdir(path1))))

到此这篇关于python实现MD5进行文件去重的示例代码的文章就介绍到这了,更多相关python MD5文件去重内容请搜索易盾网络以前的文章或继续浏览下面的相关文章希望大家以后多多支持易盾网络!