引言

之前有些无聊(呆在家里实在玩的腻了),然后就去B站看了一些python爬虫视频,没有进行基础的理论学习,也就是直接开始实战,感觉跟背公式一样的进行爬虫,也算行吧,至少还能爬一些东西,hhh。我今天来分享一个我的爬虫代码。

正文

话不多说,直接上完整代码

ps:这个代码有些问题 每次我爬到fate的图片它就给我报错,我只好用个try来跳过了,如果有哪位大佬能帮我找出错误并给与纠正,我将不胜感激

import requests as r

import re

import os

import time

file_name = "动漫截图"

if not os.path.exists(file_name):

os.mkdir(file_name)

for p in range(1,34):

print("--------------------正在爬取第{}页内容------------------".format(p))

url = 'https://www.acgimage.com/shot/recommend?page={}'.format(p)

headers = {"user-agent"

: "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/80.0.3987.162 Safari/537.36"}

resp = r.get(url, headers=headers)

html = resp.text

images = re.findall('data-original="(.*?)" ', html)

names =re.findall('title="(.*?)"', html)

#print(images)

#print(names)

dic = dict(zip(images, names))

for image in images:

time.sleep(1)

print(image, dic[image])

name = dic[image]

#name = image.split('/')[-1]

i = r.get(image, headers=headers).content

try:

with open(file_name + '/' + name + '.jpg' , 'wb') as f:

f.write(i)

except FileNotFoundError:

continue

先导入要使用的库

import requests as r import re import os import time

然后去分析要去爬的网址: https://www.acgimage.com/shot/recommend

下图是网址的内容:

好了 url已经确定

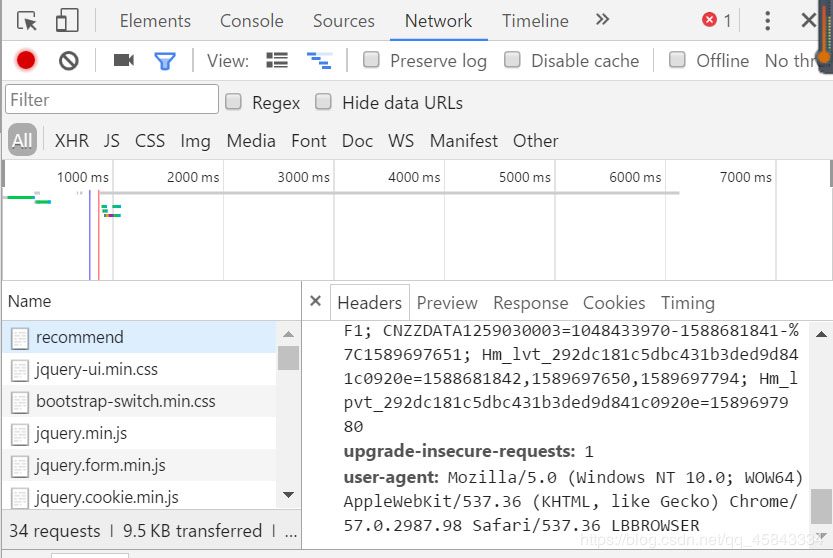

下面去寻找headers

找到user-agent 将其内容复制到headers中

第一步就完成了

下面是代码展示

url = 'https://www.acgimage.com/shot/recommend?page={}'.format(p)

headers = {"user-agent"

: "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/80.0.3987.162 Safari/537.36"

}

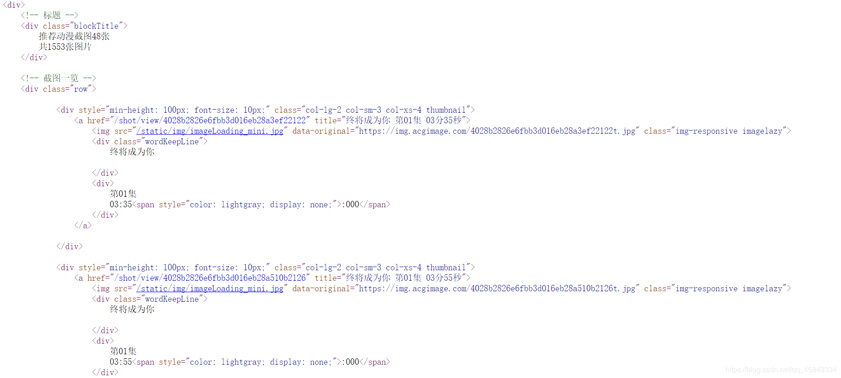

然后检索要爬的图片内容

从上图就可以找到图片的位置:data-origina=后面的内容

以及图片的名字:title=后面的内容

然后用正则表达式re来检索就行了

images = re.findall('data-original="(.*?)" ', html)

names =re.findall('title="(.*?)"', html)

最后将其保存就好了

i = r.get(image, headers=headers).content

with open(file_name + '/' + name + '.jpg' , 'wb') as f:

f.write(i)

还有就是一些细节了

比如换页

第一页网址:

https://www.acgimage.com/shot/recommend

第二页网址:https://www.acgimage.com/shot/recommend?page=2

然后将page后面的数字改动就可以跳到相应的页面

换页的问题也就解决了

or p in range(1,34):

url = 'https://www.acgimage.com/shot/recommend?page={}'.format(p)

以及将爬到的图片放到自己建立的文件zh

使用了os库

file_name = "动漫截图" if not os.path.exists(file_name): os.mkdir(file_name)

以及为了不影响爬取的网站 使用了sleep函数

虽然爬取的速度慢了一些

但是这是应遵守的道德

time.sleep(1)

以上 这就是我的爬虫过程

还是希望大佬能解决我的错误之处

万分感谢

总结

到此这篇关于python爬虫实例之获取动漫截图的文章就介绍到这了,更多相关python爬虫获取动漫截图内容请搜索易盾网络以前的文章或继续浏览下面的相关文章希望大家以后多多支持易盾网络!