以往理解的全连接神经网络的作用,是个memory,是用来分类, 而近期发现,全连接神经网络其实是学到了 L层每个输入节点 对 L+1层每个输出节点 的加权求和贡献比,每个边是一个权重

以往理解的全连接神经网络的作用,是个memory,是用来分类,

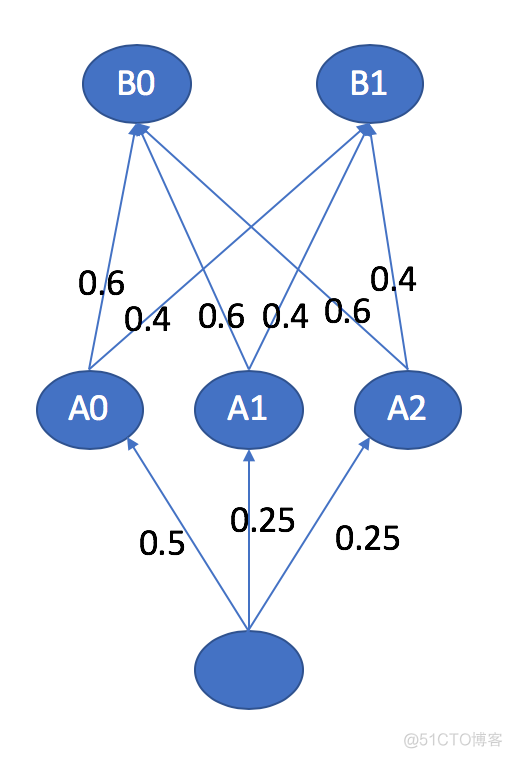

而近期发现,全连接神经网络其实是学到了 L层每个输入节点 对 L+1层每个输出节点 的加权求和贡献比,每个边是一个权重也就是一个输入节点到一个输出节点的贡献

其实就是attention

回想transformer里的K、V、Q,是可以把attention matrix看成全连接层的,

[batch,seq_len1,seq_len2] 矩阵乘 [batch,seq_len2,hidden_size] = [batch,seq_len1,hidden_size] 即attention matrix [batch, seq_len1, seq_len2]是在学输入的seq_len2个节点对输出的seq_len1个节点的加权求和贡献比