- 数据清洗

- 重复值处理

- 缺失值处理

- 查看缺失值

- 缺失值删除

- 缺失值填补

- 数据类型转换

- 文本处理

数据分析中,数据清洗是一个必备阶段。数据分析所使用的数据一般都很庞大,致使数据不可避免的出现重复、缺失、格式错误等异常数据,如果忽视这些异常数据,可能导致分析结果的准确性。

用以下数据为例,进行讲解数据清洗常用方式:

下面的操作只做示例,具体数据的清洗方式要根据数据特性进行选择!

重复值处理重复值处理,一般采用直接删除重复值的方式。在pandas中,可以用duplicated函数进行查看和drop_duplicates函数删除重复数据。

如下所示,可以通过duplicated函数查看重复的数据:

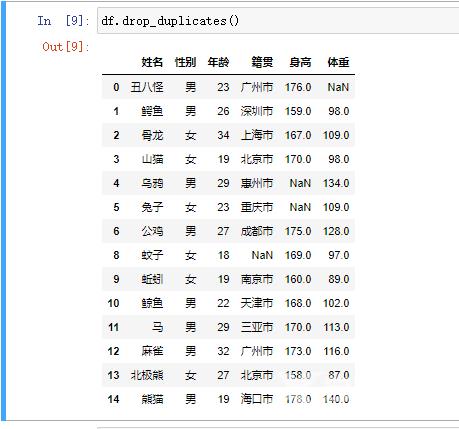

需要删除重复值时,可直接用drop_duplicates函数完成:

缺失值与重复值一样,都是数据中比较常见的问题,必须进行处理才能进行下一步分析,保证分析的准确性。缺失值在数据中一般用NaN表示,在处理缺失值时,一般采用删除和填补方式进行处理。但在实际中,缺失值的处理是一件非常困难的事情,删除和填补方式都无法解决,最后只能留着。

在pandas中,其有多种方式查看和处理缺失值的方法。

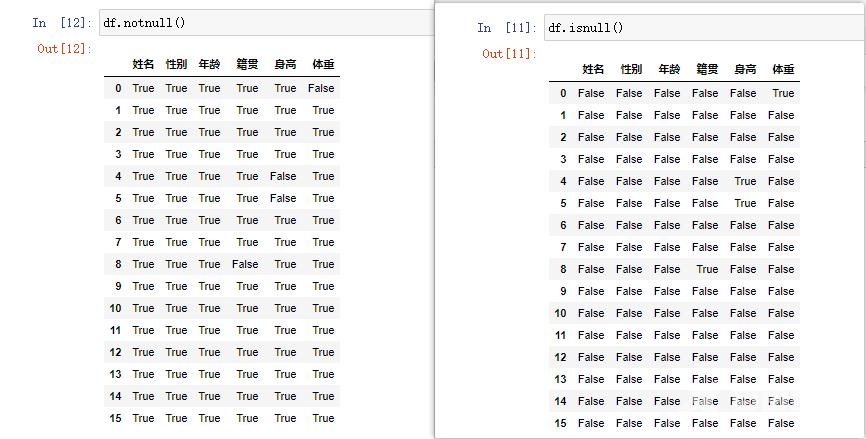

查看缺失值最为基础的可以通过isnull和notnul,或者info函数来实现。

用info函数可以很清楚的知道每一列的缺失值情况,进而做出判断处理:

isnull函数为判断序列元素是否为缺失,notnul函数判断序列元素是否不为缺失,二者在本质上是一样的。而二者在数据量庞大时,效果很差。所以一般不会单独使用,而是配合其它方法进行使用。

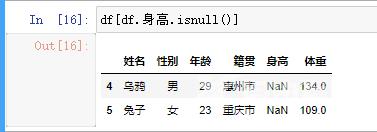

查看某列缺失值所在的行:

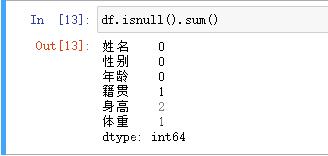

isnull函数配合sum函数计算每列缺失值的个数:

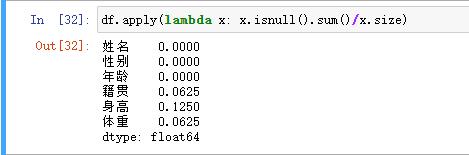

在多数查看缺失值中,经常会采用计算缺失值在列中占比的方式,判断缺失对数据具有多大的影响,从而选择是删除数据还是填补数据。计算占比可使用以下方式:

df.apply(lambda x: x.isnull().sum()/x.size)

x.size为各个数据列总行数:

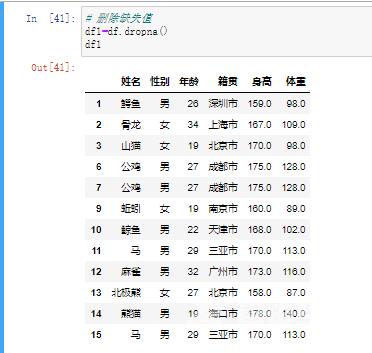

删除缺失值的情形,一般是在不会影响分析结果、造成的影响无伤大雅,或者难以填补的时候采用。

在pandas中,可以直接用dropna函数进行删除所有含有缺失值的行,或者选择性删除含有缺失值到的行:

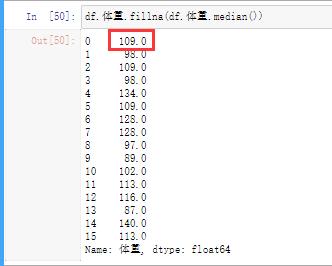

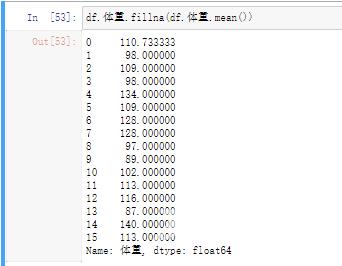

在无法直接删除缺失值时,或者包含缺失值的行具有很多而无法选择性删除时,填补是最佳的选择,但填补的方式要根据数据来选择,否则填补的数据依然会影响分析的准确性。

在pandas中,可以使用fillna函数完成对缺失值的填补,例如对表中的体重列进行填补,填补方法为中位数:

或者用平均值填补:

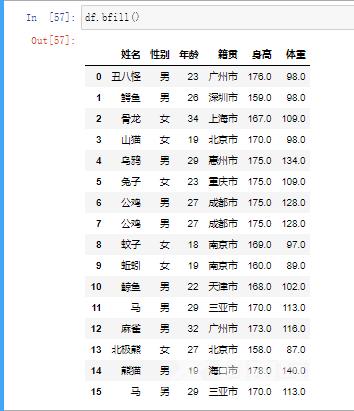

也可以用pandas中的ffill函数对缺失值进行前向填补,但在前向填补时需要注意各个列数据的情况:

但可以看到,体重列的第一行未填补完成,而pandas中提供了bfill函数进行后向填补:

数据类型关乎后面的数据处理和数据可视化,不同的数据类型处理和进行可视化的用法都不一样,因此,事先把数据的类型转换好,利于后面的相关步骤。

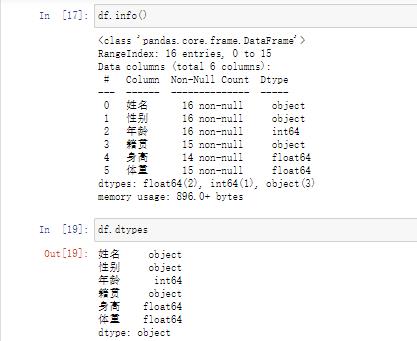

在pandas中,可以用info和dtypes方法进行查看数据类型:

常用的数据类型包括str(字符型)、float(浮点型)和int(整型)。当某列数据的类型出现错误时,可通过astype函数进行强制转换数据类型。

例如下面通过astype函数对数值型列转换为字符型:

在数据中,文本在某种程度上可以说是最‘脏’的数据,不管在录入的数据,还是爬取的数据,总会出现各种各样的‘脏’数据,处理难度非常高。在处理中,主要是切分字符串、值替换。

pandas提供了df.str.split.str()方法对字符串的切割,以下通过此方法获得地级市名称:

对于一些多数词,可以通过df.str.replace()方法进行增加、替换或者删除:

到此这篇关于用Python进行数据清洗以及值处理的文章就介绍到这了,更多相关Python进行数据清洗内容请搜索自由互联以前的文章或继续浏览下面的相关文章希望大家以后多多支持自由互联!