NAACL 2019

解决的问题本文解决的问题是ABAS问题,也就是针对句子中对于不同方面的评价,提取对于不同方面评价的感情态度。这一问题的提出是由于统一句子中可能出现对事物不同角度的不同情感倾向的评价,例如:这本书是精装的,但是价格有点贵。显然对于外表是正向评价,对价格是负面评价。

使用方法整个任务分为两部分:将(T)ABSA问题转换为一个句子对的分类任务;使用预训练模型BERT训练。以下为详细介绍:

任务描述对TABSA问题,任务给出如下数据:

句子:\(\{w_1,...,w_m\}\),

句子中的词:\(\{w_{i1},...,w_{ik}\}\)

预先定义好的target:\(\{t_1,...t_k\}\),是句子中所有词的子集。

aspect集合A:\(\{general,price,transitlocation,safety\}\)

预测极性集合y:\(\{positive,negative,none\}\)

问题: 对(target,aspect)对来判断极性。

而ABSA问题不存在预设的target,其余与上述定义一致

构建辅助句构建辅助句可以采用如下四种方式(大体上分为QA方式和NLI方式,两种方式中各包括一个情感分类和一个yes/no分类),以下举例时均考虑针对(location,safety)这样一个(target,aspect)的构建:

QA-M:使用QA构造的是一个问句。

例:what do you think of the safety of location - 1 ?

NLI-M:使用NLI方式构造问句

例:location - 1 - safety

QA-B:QA构造分类句,可能产生三种类型句子,对应三种情感极性,使用可能性作为选择三者之一的标准。

例:the polarity of the aspect safety of location - 1 is positive/negative/none

NLI-B:和QA-B不同之处在于生成的是一个pseudo-sentence 。

例:location - 1 - safety - negative/positive/none

微调BERT把最后的hidden state(transformer的输出)作为输入(H维),通过一个全连接层$$(W ∈ R K ∗ H W\in\mathbb{R}^{K*H}W∈R

K∗H

),$$K 是要分类的类别数,最后使用softmax得到概率。

Bert-singe:

对TABSA——\(n_t\)个target,\(n_a\)个aspect,把这个任务看成\(n_t*n_a\)的target-aspect分类任务,然后求和。

对ABSA \(n_a\)个aspect的分类任务

Bert-pair: 上述四种构建辅助句子的方法各自是一个句子对分类任务

创新点本文从aspect构造了一个辅助句子,并将 ABSA 转换为句子对分类任务。(由于BERT的输入表示可以表示单个文本句子和一对文本句子,我们可以将 (T)ABSA 转换为句子对分类任务并微调预训练的 BERT)

实验数据 数据集- SentiHood(TABSA)

- SemEval2014 Task 4(ABSA)

使用预训练的BERT模型,12个transformer的block,768层,总体参数为110M。

对比算法- Exp-I: TABSA:

LR、LSTM-Final、LSTM+TA+SA、SenticLSTM、Dmu-Entnet - Exp-II: ABSA:

XRCE、NRC-Canada

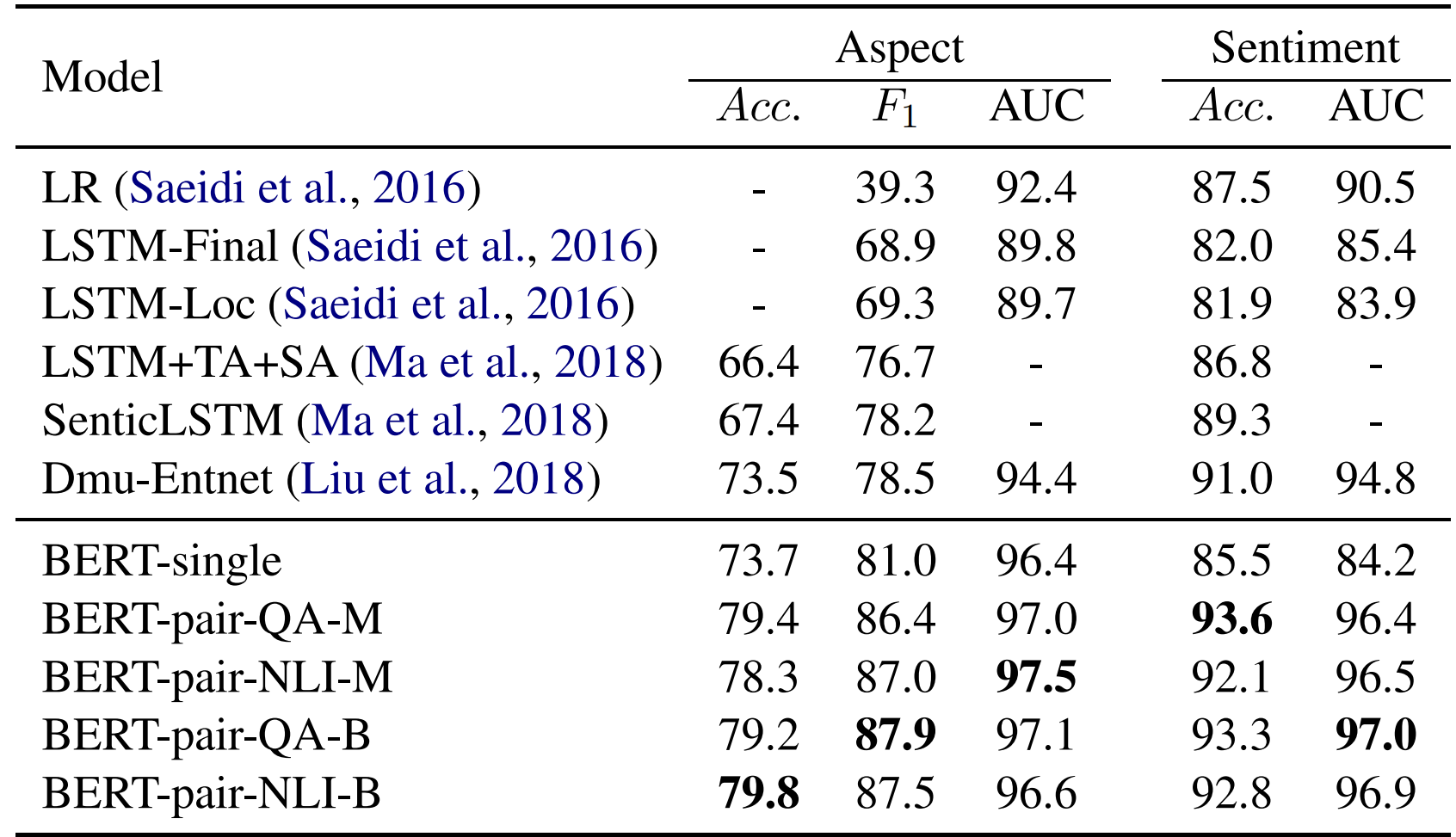

SentiHood上 TABSA 的表现结果

简单总结:在Aspect detection和Sentiment analysis两个任务中,BERT基于句对的方法均较优。同时,不同句对在不同方面各具有优势。

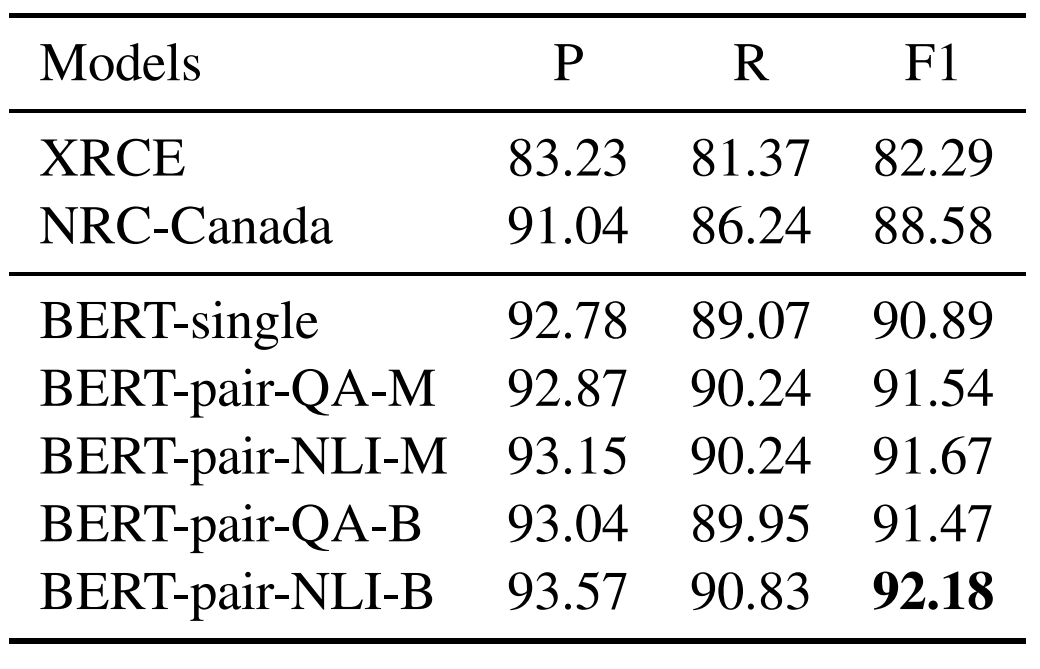

ABSA:Test set results for Semeval-2014 task 4 Sub-task 3:Aspect Category Detection

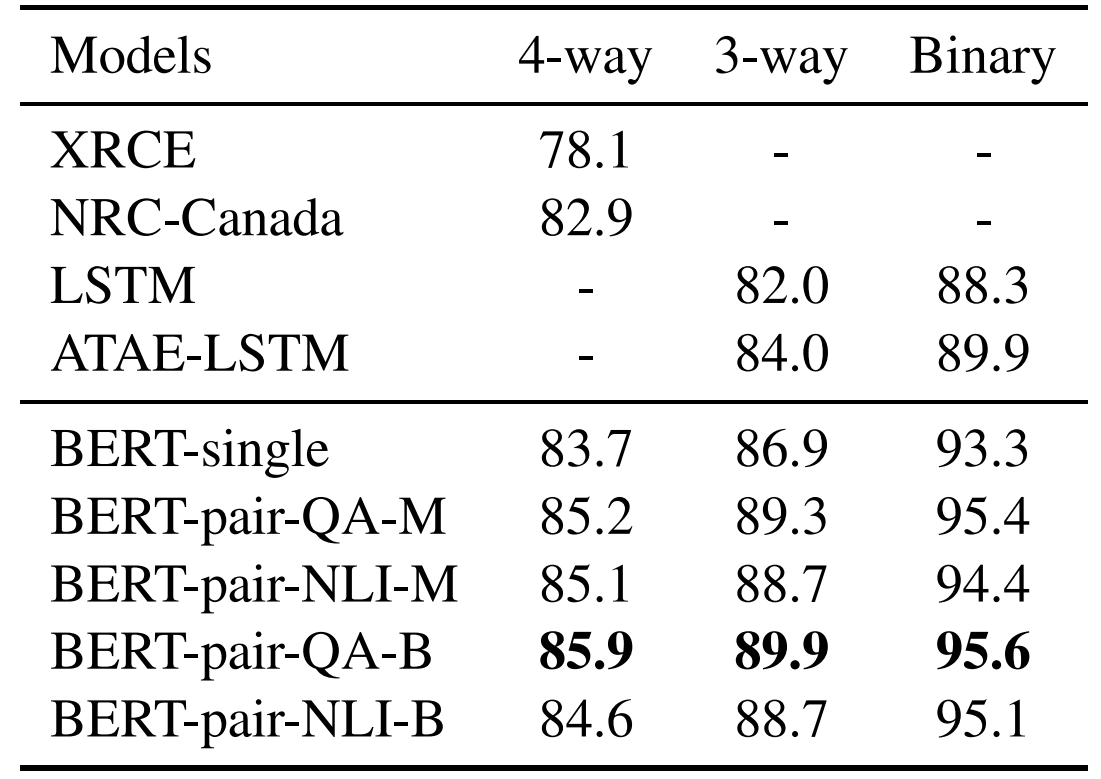

ABSA:Test set accuracy (%) for Semeval-2014 task4 Subtask 4: Aspect Category Polarity

简单总结:在Aspect detection和Sentiment analysis两个任务中,BERT的方法均较优。

感受此论文方法能达到较优效果的可能原因如下:一方面,将目标和方面信息转换为辅助句,相当于指数式地扩展语料库;另一方面,BERT 模型在处理句对分类任务方面具有优势。

对于ABSA问题,和篇章级和句子级的情感分析相比面临的问题有如下:1.方面级情感分析需要获取文本中的评价对象方面信息。评价对象方面可能显式的出现在文本中,也可能隐式的包含在文本语义中。因为方面的形式和数量都不确定,所以方面级情感分析技术不仅要对显式的语言表达结构进行分析,还要对隐式的语义表达进行深层理解;2.方面级情感分析需要为每个评价对象确定对其表达情感的上下文范围。自然语言不但表达连贯、用语灵活,指代词等表达方式也非常普遍。方面级情感分析技术需要正确理解了文本词语级和句子级的语义信息,才能正确地界定对各个评价对象方面进行情感表达的上下文范围。

本文和文中提出的一些方法都是预设一些aspect之后针对这些aspect进行分析,因此上述问题出现的不太明显。个人认为如果需要从句子中提取aspect,或是分析隐式的aspect,任务难度将会加大。

本文的创新在于引入辅助句,将aspect情感分析问题转化为句对分类问题,充分利用BERT的优势。个人认为这样处理相当于把一个相对抽象,相对宏观的问题细分,对每个小问题逐步求解,如果每个小问题的求解相对容易,这样划分或许或获得较好的结果。

(由于目前NLP论文看的不多,感叹一下BERT太强大了。)