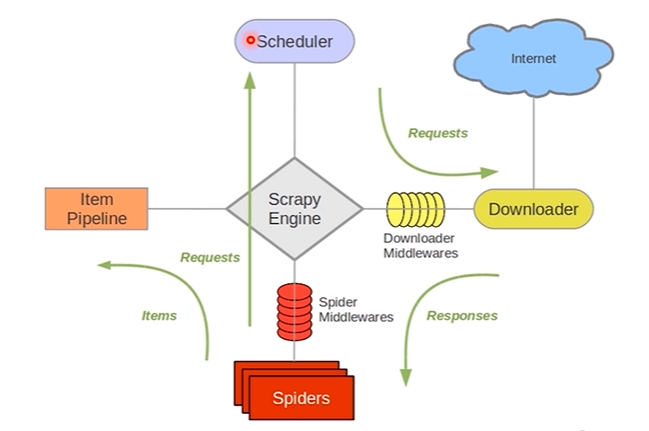

什么是Scrapy 基于Twisted的异步处理框架 纯python实现的爬虫框架 基本结构:5+2框架,5个组件,2个中间件 5个组件: Scrapy Engine: 引擎,负责其他部件通信 进行信号和数据传递;负责Sch

- 基于Twisted的异步处理框架

- 纯python实现的爬虫框架

- 基本结构:5+2框架,5个组件,2个中间件

5个组件:

- Scrapy Engine:引擎,负责其他部件通信 进行信号和数据传递;负责Scheduler、Downloader、Spiders、Item Pipeline中间的通讯信号和数据的传递,此组件相当于爬虫的“大脑”,是整个爬虫的调度中心

- Scheduler:调度器,将request请求排列入队,当引擎需要交还给引擎,通过引擎将请求传递给Downloader;简单地说就是一个队列,负责接收引擎发送过来的 request请求,然后将请求排队,当引擎需要请求数据的时候,就将请求队列中的数据交给引擎。初始的爬取URL和后续在页面中获取的待爬取的URL将放入调度器中,等待爬取,同时调度器会自动去除重复的URL(如果特定的URL不需要去重也可以通过设置实现,如post请求的URL)

- Downloader:下载器,将引擎engine发送的request进行接收,并将response结果交还给引擎engine,再由引擎传递给Spiders处理

- Spiders:解析器,它负责处理所有responses,从中分析提取数据,获取Item字段需要的数据,并将需要跟进的URL提交给引擎,再次进入Scheduler(调度器);同时也是入口URL的地方

- Item Pipeline:数据管道,就是我们封装去重类、存储类的地方,负责处理 Spiders中获取到的数据并且进行后期的处理,过滤或者存储等等。当页面被爬虫解析所需的数据存入Item后,将被发送到项目管道(Pipeline),并经过几个特定的次序处理数据,最后存入本地文件或存入数据库

2个中间件:

- Downloader Middlewares:下载中间件,可以当做是一个可自定义扩展下载功能的组件,是在引擎及下载器之间的特定钩子(specific hook),处理Downloader传递给引擎的response。通过设置下载器中间件可以实现爬虫自动更换user-agent、IP等功能。

- Spider Middlewares:爬虫中间件,Spider中间件是在引擎及Spider之间的特定钩子(specific hook),处理spider的输入(response)和输出(items及requests)。自定义扩展、引擎和Spider之间通信功能的组件,通过插入自定义代码来扩展Scrapy功能。

Scrapy操作文档(中文的):https://www.osgeo.cn/scrapy/topics/spider-middleware.html

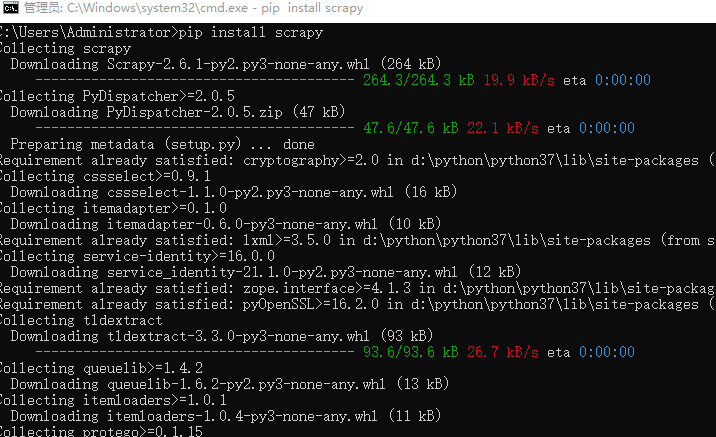

Scrapy框架的安装

cmd窗口,pip进行安装

pip install scrapy

Scrapy框架安装时常见的问题

找不到win32api模块----windows系统中常见

pip install pypiwin32

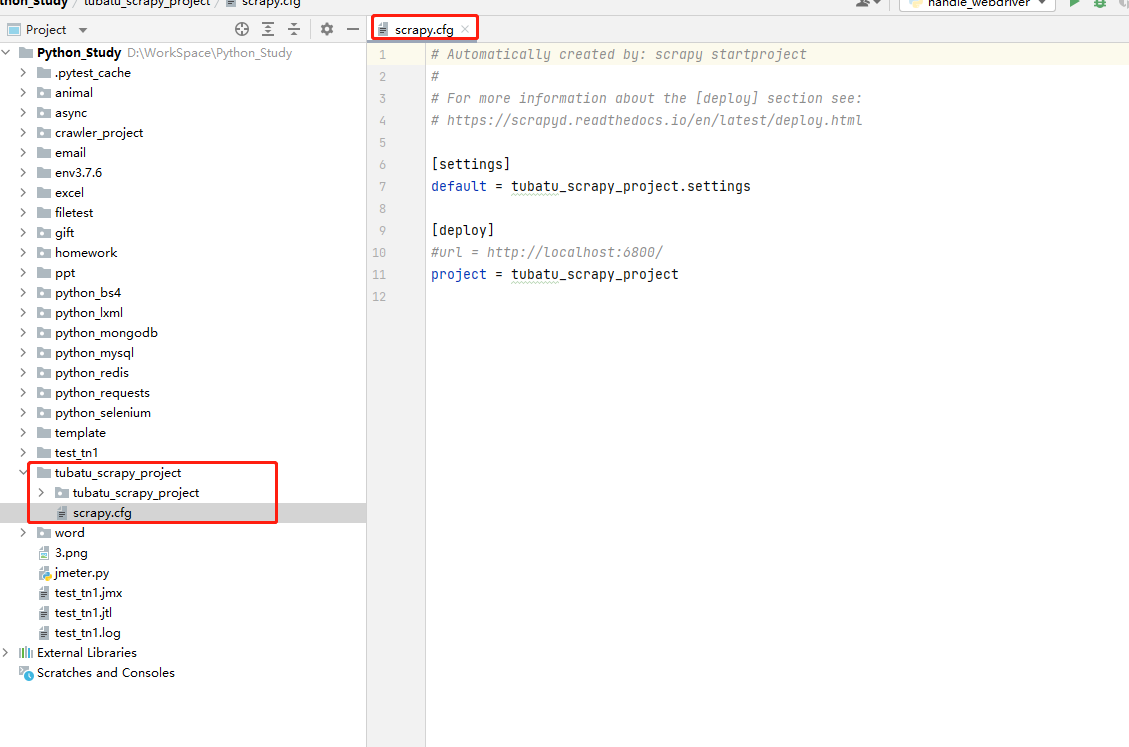

创建Scrapy爬虫项目 新建项目

scrapy startproject xxx项目名称

实例:

scrapy startproject tubatu_scrapy_project

项目目录

scrapy.cfg:项目的配置文件,定义了项目配置文件的路径等配置信息

- 【settings】:定义了项目的配置文件的路径,即./tubatu_scrapy_project/settings文件

- 【deploy】:部署信息

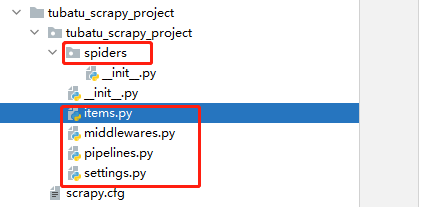

- items.py:就是我们定义item数据结构的地方;也就是说我们想要抓取哪些字段,所有的item定义都可以放到这个文件中

- pipelines.py:项目的管道文件,就是我们说的数据处理管道文件;用于编写数据存储,清洗等逻辑,比如将数据存储到json文件,就可以在这边编写逻辑

- settings.py:项目的设置文件,可以定义项目的全局设置,比如设置爬虫的 USER_AGENT ,就可以在这里设置;常用配置项如下:

- ROBOTSTXT_OBEY :是否遵循ROBTS协议,一般设置为False

- CONCURRENT_REQUESTS :并发量,默认是32个并发

- COOKIES_ENABLED :是否启用cookies,默认是False

- DOWNLOAD_DELAY :下载延迟

- DEFAULT_REQUEST_HEADERS :默认请求头

- SPIDER_MIDDLEWARES :是否启用spider中间件

- DOWNLOADER_MIDDLEWARES :是否启用downloader中间件

- 其他详见链接

- spiders目录:包含每个爬虫的实现,我们的解析规则写在这个目录下,即爬虫的解析器写在这个目录下

- middlewares.py:定义了 SpiderMiddleware和DownloaderMiddleware 中间件的规则;自定义请求、自定义其他数据处理方式、代理访问等

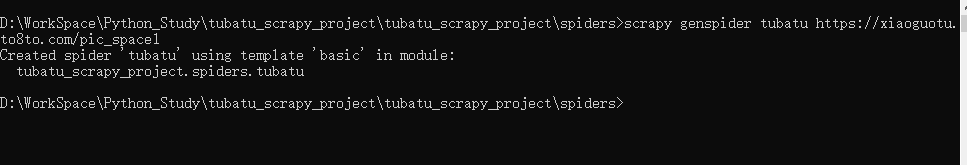

自动生成spiders模板文件

cd到spiders目录下,输出如下命令,生成爬虫文件:

scrapy genspider 文件名 爬取的地址

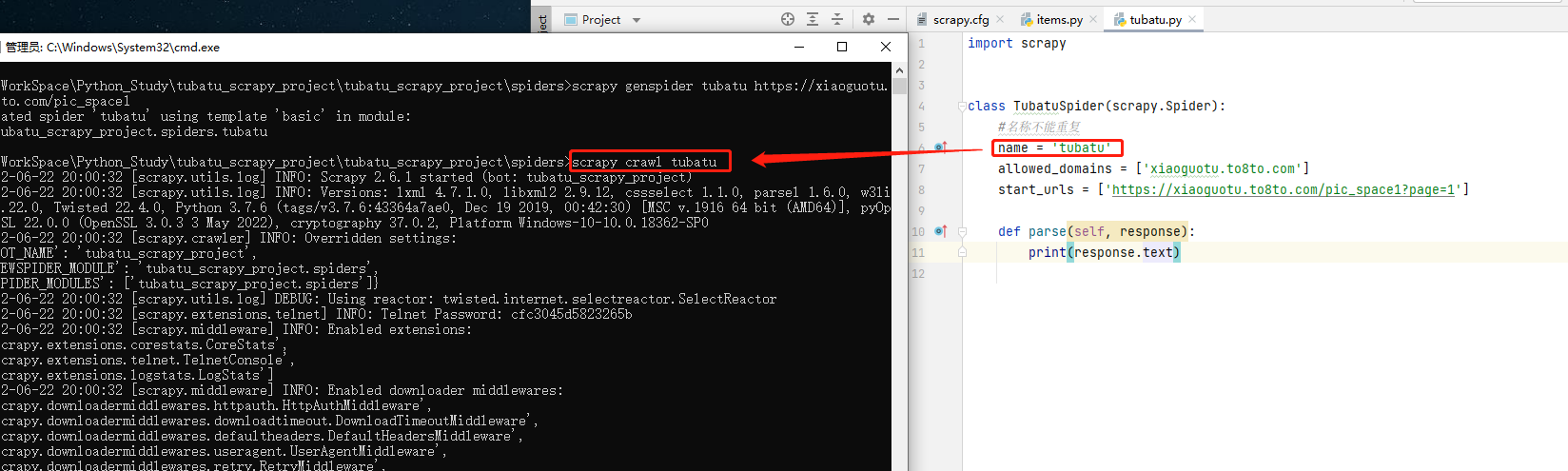

运行爬虫

方式一:cmd启动

cd到spiders目录下,执行如下命令,启动爬虫:

scrapy crawl 爬虫名

方式二:py文件启动

在项目下创建main.py文件,创建启动脚本,执行main.py启动文件,代码示例如下:

code-爬虫文件