需求:将orc格式的数据文件同步数据到mysql数据库 由于orc格式的文件不能直接通过文本编辑器打开,也不是说简单的通过记事本写入一些数据,把扩展名改成orc就可以了 为了生成标准的

需求:将orc格式的数据文件同步数据到mysql数据库

由于orc格式的文件不能直接通过文本编辑器打开,也不是说简单的通过记事本写入一些数据,把扩展名改成orc就可以了

为了生成标准的orc格式文件,我们通过hive创建orc表,然后到hdfs上面把相应的保存文件下载下来,这样我们就可以明确我们表的字段信息和数据内容了

一、添加依赖包

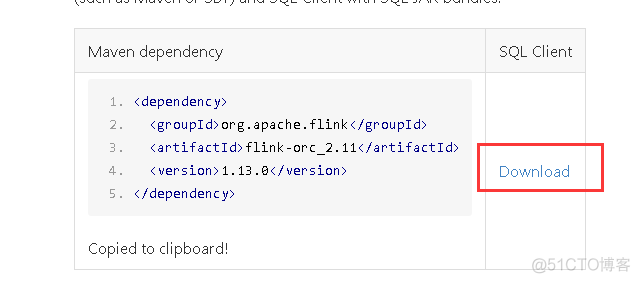

在dinky的plugins目录和flink的lib目录下,添加orc依赖jar包,并重启dinky和flink

下载地址参考:https://www.bookstack.cn/read/ApacheFlink-1.13-zh/6f9399b3e1a8dd04.md

再次提醒,下载的时候注意flink的版本,要跟自己的flink版本匹配

二、创建作业

我这里提前把orc文件下载过来了,是通过hive创建orc格式的表,然后在hive表插入数据

三、编写flinksql代码

CREATE TABLE fs_table (`id` STRING,

`name` STRING,

`sex` STRING,

`age` STRING,

`work` STRING

) WITH (

'connector'='filesystem',

'path'='file:///home/data/orc',

'format'='orc'

);

CREATE TABLE orc_out(

`id` STRING,

`name` STRING,

`sex` STRING,

`age` STRING,

`work` STRING

) WITH (

'connector' = 'jdbc',

'url' = 'jdbc:mysql://172.16.119.50:3306/test?createDatabaseIfNotExist=true&useSSL=false',

'username' = 'root',

'password' = 'Tj@20220710',

'table-name' = 'orc_out'

);

INSERT INTO orc_out select id,name,sex,age,work from

四、运行作业

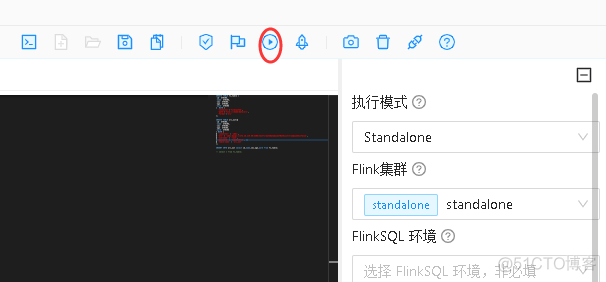

检查语法没有问题后,直接运行作业

选定提前部署的flink集群,并运行作业

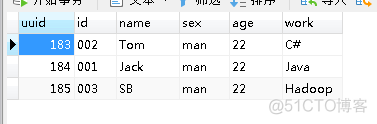

运行结束后查看mysql的数据,已经同步过来了