目录 哈希数据类型的创建与数据的添加 - hmset 哈希数据类型已存在的记录添加记录 - hset 哈希数据类型已存在的记录删除记录 - hdel 哈希数据类型判断某记录是否存在 - hexists 获取哈希数

目录

- 哈希数据类型的创建与数据的添加 - hmset

- 哈希数据类型已存在的记录添加记录 - hset

- 哈希数据类型已存在的记录删除记录 - hdel

- 哈希数据类型判断某记录是否存在 - hexists

- 获取哈希数据类型的所有元素 - hgetall

- 哈希数据类型相关指令演示小案例

哈希数据类型的创建与数据的添加 - hmset

利用 “redis-py” 模块实现 “哈希数据类型” 的创建及哈希表数据的添加。

con.hmset("userinfo", {"name": "Jack", "age": 16, "sex": "man"})

# 这里的 con 就是创建的连接的变量

# hmset 指令实现定义创建哈希表,并添加哈希表的内容数据

哈希数据类型已存在的记录添加记录 - hset

利用 “redis-py” 模块针对已经存在的 “哈希数据类型” 添加新的记录。

con.hset("userinfo", "hight", 166)

# 这里的 con 就是创建的连接的变量

# hset 指令实现针对已经存在哈希表添加新的属性内容

哈希数据类型已存在的记录删除记录 - hdel

利用 “redis-py” 模块针对已经存在的 “哈希数据类型” 删除记录。

con.hdel("userinfo", "sex")

# 这里的 con 就是创建的连接的变量

# hdel 指令实现针对已经存在哈希表的内容执行删除操作

哈希数据类型判断某记录是否存在 - hexists

利用 “redis-py” 模块,判断已经存在的 “哈希数据类型” 是否存在某项记录。

con.hexists("userinfo", "name")

# 这里的 con 就是创建的连接的变量

# hexists 指令实现针对已经存在哈希表的内容,判断某项记录是否存在

获取哈希数据类型的所有元素 - hgetall

在 “redis-py” 模块,获取 “哈希数据类型” 全部的元素记录与 “redis” 也是一样的指令。

result = con.hgetall("userinfo")

# 这里的 con 就是创建的连接的变量

# hgetall 指令实现针对已经存在哈希表的内容,获取该哈希表的全部元素内容

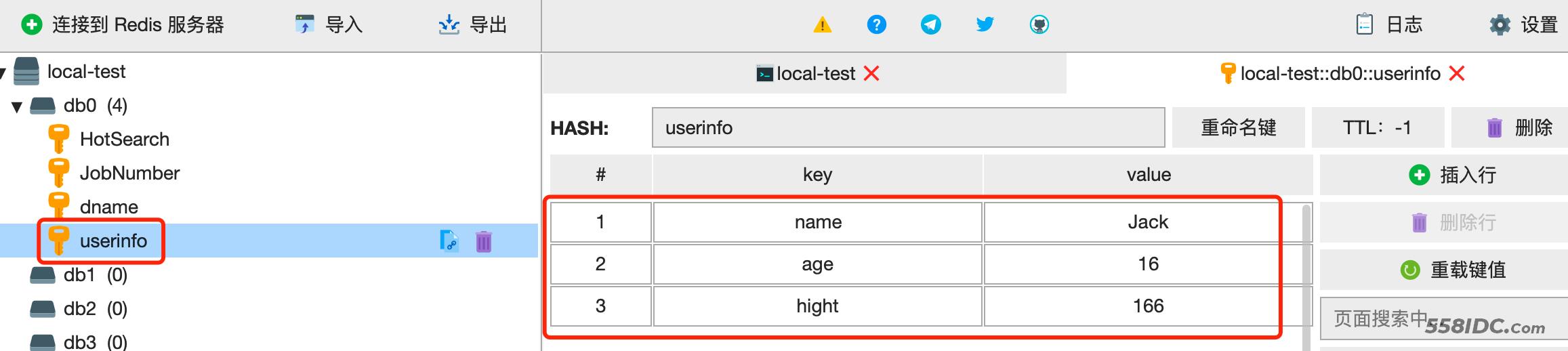

哈希数据类型相关指令演示小案例

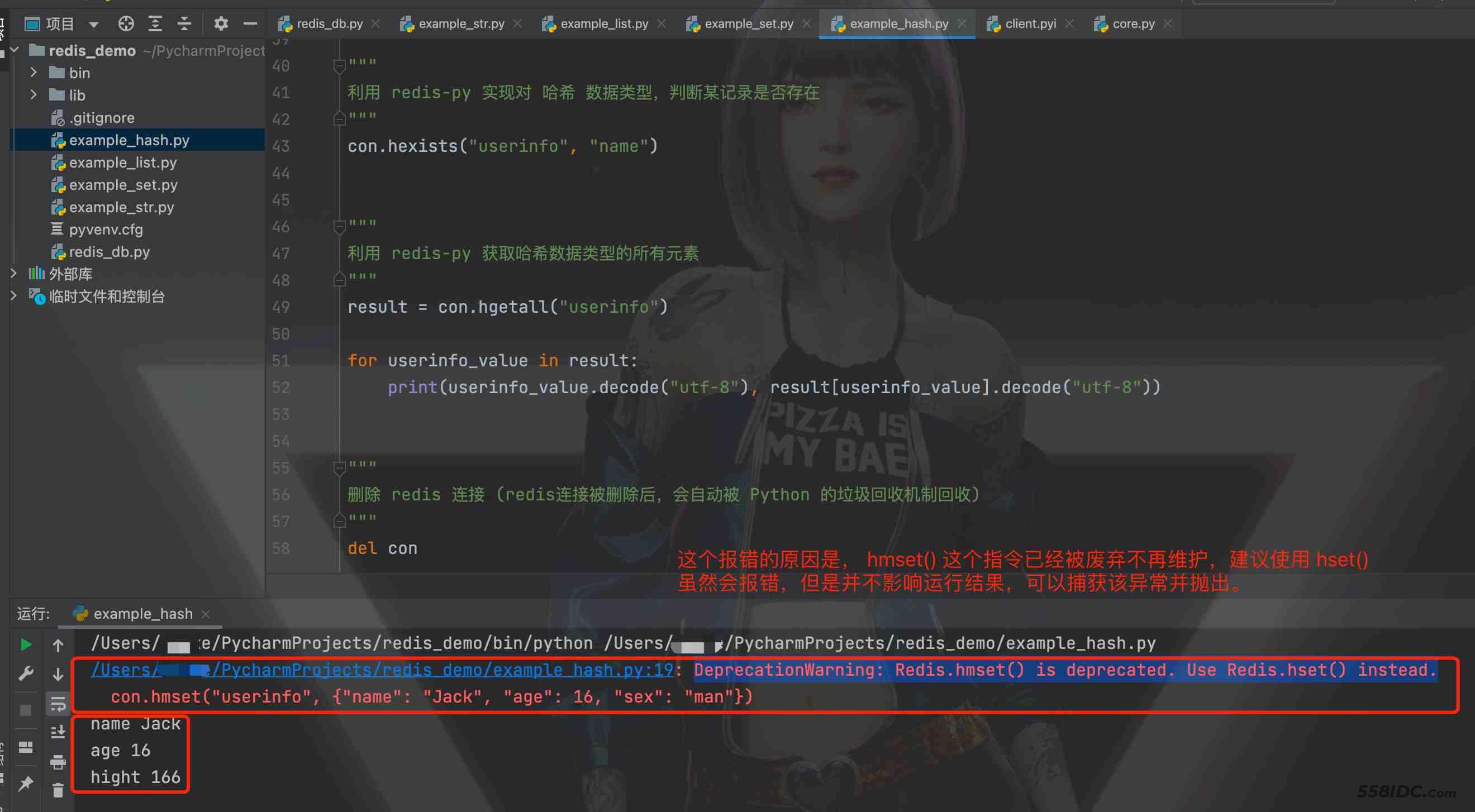

example_hash.py 模块演示案例如下:(其实这里同样应该使用 try...except...finally 进行异常捕获,但是我依然懒得写了...)

# coding:utf-8

import redis

from redis_db import redis_Pool # 导入 redis_db模块 的 redis_Pool

"""

创建 redis 连接

"""

con = redis.Redis(

connection_pool=redis_Pool

)

"""

利用 redis-py 实现对 哈希 数据类型的添加操作(逻辑库 0)

"""

con.hmset("userinfo", {"name": "Jack", "age": 16, "sex": "man"})

"""

利用 redis-py 实现对 哈希 数据类型已存在的记录添加记录

"""

con.hset("userinfo", "hight", 166)

"""

利用 redis-py 实现对 哈希 数据类型已存在的记录删除记录

"""

con.hdel("userinfo", "sex")

"""

利用 redis-py 实现对 哈希 数据类型已存在的记录删除记录

"""

con.hdel("userinfo", "sex")

"""

利用 redis-py 实现对 哈希 数据类型,判断某记录是否存在

"""

con.hexists("userinfo", "name")

"""

利用 redis-py 获取哈希数据类型的所有元素

"""

result = con.hgetall("userinfo")

for userinfo_value in result:

print(userinfo_value.decode("utf-8"), result[userinfo_value].decode("utf-8"))

"""

删除 redis 连接 (redis连接被删除后,会自动被 Python 的垃圾回收机制回收)

"""

del con

到此这篇关于Python利用redis-py实现哈希数据类型的常用指令操作的文章就介绍到这了,更多相关Python redis-py哈希数据类型内容请搜索自由互联以前的文章或继续浏览下面的相关文章希望大家以后多多支持自由互联!