来源计算广告

四年前谷歌旗下DeepMind公司开发的围棋人工智能AlphaGo以4-1战胜韩国大国手李世乭九段。

今天AlphaGo在大众视野中掀起的惊涛骇浪已渐平息AlphaGo和李世乭都已从江湖退隐。

然而围棋界因AlphaGo而起的沧桑巨变仍在进行时。

那么人工智能与人类棋士的差距究竟有多大呢

柯洁当年的豪言“AlphaGo能赢李世乭但赢不了我”又是否可信呢

1

棋力的量化标准

自李世乭、柯洁先后不敌AlphaGo之后人类棋士被AlphaGo超越已成共识。

不过AlphaGo以及其他围棋AI具体比人类棋士强多少仍是众说纷纭。

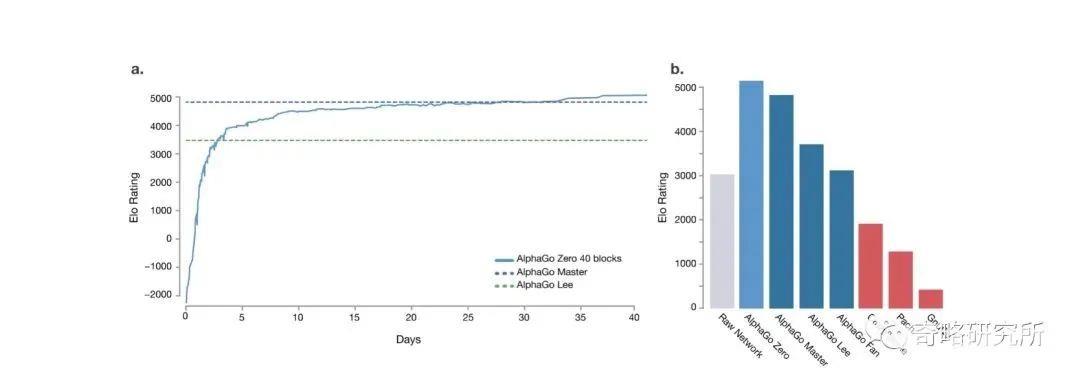

实际上AlphaGo的开发团队在《自然》期刊介绍AlphaGo Zero的论文《无需人类知识的围棋大师》(“Mastering the Game of Go without Human Knowledge”)中已给出了一个量化标准。

论文中采用的量化标准基于Elo等级分系统。

Elo等级分是美国物理学家阿尔帕德·埃洛Arpad I. Elo在1960年发明的最初用于量化国际象棋棋士实力。

Elo等级分基于统计学评估棋士实力。

首先Elo赋予新参与等级分体系的棋手初始等级分。

以中国围棋职业棋手等级分为例1995年颁布时以当时的职业段位确定初始分。

具体标准为九段2560分、八段2520分、七段2480分、六段2440分、五段2400分、四段2360分、三段2320分、二段2280分、初段2240分。

聂卫平、马晓春两位九段因成绩特别突出被赋予2600分的初始分同列榜首。

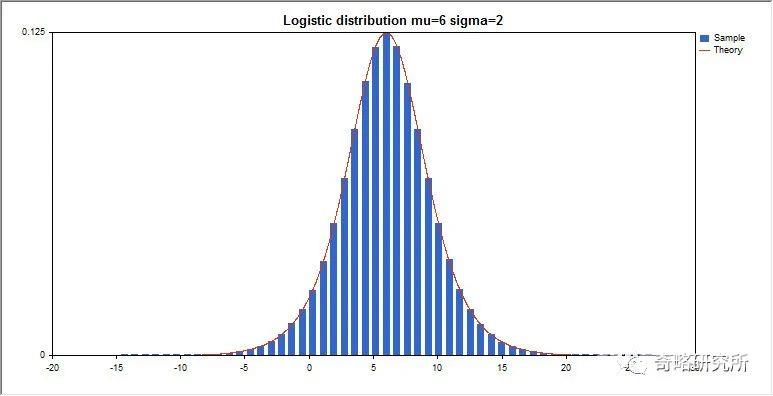

然后Elo假设棋士的实力遵从增长分布Logistic Distribution。

基于这项假设棋士之间的期望胜率可以被计算。

而在棋士每赢或输一盘棋之后其实际胜率会偏离此前的理论计算因此需要按照公式调整棋手的等级分。

Figure1增长分布

若有A、B两位棋手他们的分数分别是,那么根据增长分布假设可以推算棋手A对棋手B的胜率期望值是

.

.

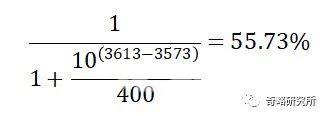

例如若当前棋手A等级分是3613分棋手B等级分是3573分那么按照上述公式理论上棋手A对战棋手B的胜率是55.73%,计算过程如下。

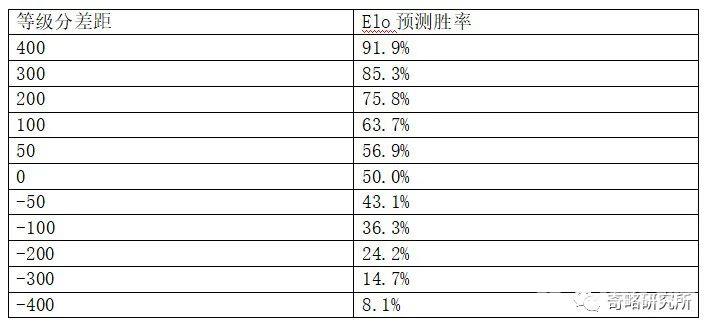

等级分差距与期望胜率的对应关系见下表

现在A和B下了一盘棋之后B获胜那么系统自然需要调高B的等级分而调低A的等级分具体按照以下公式

其中是棋手A调整后的分数是棋手A的调整前分数在这个例子里是3613分。

K是一个控制等级分变化率的常数通常级别越高的比赛K值越大。

这里我们取围棋比赛里常见的K16.表示棋局结果棋手A胜、平、负则分别取1,0.5,0.这盘棋A输掉所以是A本局的期望胜率之前我们已经计算过了本局的是0.5573.根据公式我们可以求出棋手A输棋以后的调整分数。

也就是说棋手A输给B之后的新等级分是3604.08分失去了8.92分。

相应地棋手B得到了8.92分其新等级分是3581.92分。

根据上述公式棋手赢一盘棋获得的分数并不总是一样。

若棋手A的当前等级分远高于棋手B那么A胜B获得的分数就会较少而A负于B失去的等级分则会较多。

这种规则无疑比每局赢棋获得固定的等级分合理。

2

AlphaGo的自评等级分体系

AlphaGo论文当中使用的Elo等级分体系其评分基准是Go Ratings等级分。

Go Ratings等级分(www.goratings.org )是由法国科学家Rémi Coulom创立的。

此等级分不具有官方地位因而被部分棋迷调侃为“野榜”。

然而Go Ratings等级分因其更新及时每天更新、范围全包括中、日、韩、欧美等地绝大多数职业棋手而广受棋迷欢迎。

Go Ratings等级分采用Rémi Coulom首创的WHR算法。

WHR算法在Elo算法的基础上改进以更少的棋局就可以精确定位棋手的实力。

除此之外WHR可以视作Elo等级分的变种。

截至2020年4月24日Go Ratings等级分前10名的棋手见下图

Figure 2 Go Ratings等级分

其中韩国00后棋手申真谞以3731的高分排名第一中国棋手柯洁以3667分排名第二。

AlphaGo的各版本量化棋力是由DeepMind开发团队基于大样本对弈用Elo体系评估的。

其中与AlphaGo对战过的人类棋手李世乭、樊麾被选定为基准。

2015年10月樊麾与初代AlphaGoAlphaGo Fan版本对战时等级分为2900分左右其与AlphaGo的比分是2-8因此AlphaGo Fan版本的等级分被评估为3144分。

此处对AlphaGo等级分的评估也使用了WHR算法的快速定位十局棋足够估算出AlphaGo的实力。

Figure 3 AlphaGo各版本等级分评估

在第二代AlphaGo即AlphaGo Lee版本与李世乭对战之前其与初代AlphaGo之间的差距已达到让三子因此DeepMind团队在内部测试中评估此版本等级分约为4500分。

同时DeepMind负责人David Silver也在演讲中指出4500分的评价有高估可能性。

果然AlphaGo以4-1的比分战胜李世乭之后由于李世乭当时的等级分3580分左右DeepMind据此将第二代AlphaGo的等级分重新修订为3739分。

3

第二代AlphaGo的真实实力

DeepMind一次性将第二代AlphaGo的等级分评估下调近800分看似匪夷所思其实是负责任的做法。

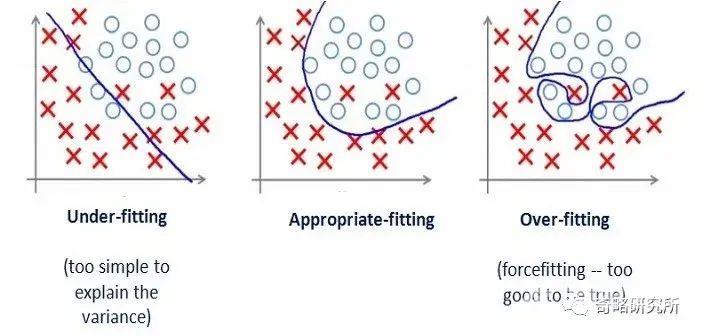

最初的4500分评估主要基于AlphaGo不同版本间的“内战”。

从算法原理上看第二代AlphaGo的模型是在第一代AlphaGo的基础上进一步训练改进的因此第二代AlphaGo清楚地“了解”前代AlphaGo的弱点特别善于对抗前代AlphaGo。

用机器学习的术语来说这是一种过拟合overfitting。

Figure 4 过拟合

AlphaGo与李世乭对战输掉的那一局是由于李世乭的“神之一挖”触发了AlphaGo一连串的低级错误。

部分科技类博主将此解读为AlphaGo出了bug并进一步推断如果不是这个偶发的bugAlphaGo的实力已经远超李世乭。

其实这种解读并不准确。

纪录片《AlphaGo》忠实地记录了AlphaGo与李世乭之战的幕后故事。

在与李世乭对战之前开发团队已经发现了AlphaGo偶然会下出愚蠢的臭棋。

并且开发团队发现这样的问题在开赛之前已来不及修复了。

世界上最优秀的人工智能开发团队只能祈祷AlphaGo在与李世乭正式对战时不要暴露这个问题。

从算法原理来看神经网络训练出现问题的修复的确非常复杂。

修复一般的程序漏洞只需要追溯与漏洞相关的逻辑迟早能查出问题所在。

而神经网络更近似于一个黑箱出现问题难以定位即使对症地修改神经网络架构或更换训练样本效果也难以预测。

因此AlphaGo与李世乭对战时的失误并非偶发的bug而是第二代AlphaGo模型的缺陷应当被视作AlphaGo实力的一部分。

DeepMind最终将第二代AlphaGo的等级分评为3739分不夸大、不粉饰缺陷体现了实事求是的科学精神。

4

“AlphaGo能赢李世乭但赢不了我”

当年李世乭在第一局输给AlphaGo之后柯洁在微博上发出豪言壮语“AlphaGo能赢李世乭但赢不了我”一时引发关注热潮。

而在李世乭与AlphaGo的系列赛结束之后李世乭则说如果让他再与AlphaGo下五局他至少能多赢一局。

柯洁

当时大部分人受AlphaGo排山倒海的气势震慑认为柯洁与李世乭的自我评价过度自信。

但如果用前文提到的棋力量化标准去分析两位顶尖棋士未必是在说大话。

柯洁发微博时他的等级分在3630分上下波动与DeepMind对AlphaGo 3739的评分相差约109分。

用Elo公式推算柯洁对AlphaGo下一盘棋胜率约为35%。假设五盘棋的胜负是独立事件那么柯洁赢下与第二代AlphaGo的概率是23.5%。

作为对比首届新奥杯决赛柯洁对阵彭立尧。

彭立尧在0-2落后之后将比分扳成2-2平并在第五局将柯洁逼到悬崖边上几乎实现惊天逆转。

彭立尧当时的等级分比柯洁低150分甚至比柯洁与第二代AlphaGo的差距更大

因此如果柯洁能够与第二代AlphaGo对战一次五番棋那么柯洁获胜并非小概率事件。

可惜柯洁的豪言终究只能是空想

如果说对战第二代AlphaGo柯洁尚有两成胜率那么柯洁在2017年真实面对第三代AlphaGo也就是AlphaGo Master之时则是十死无生。

AlphaGo Master的等级分是4858分按照公式计算柯洁的胜率是1/1176胜利是小概率中的小概率。

需要注意的是低于千分之一的胜率并非没有意义。

《体坛周报》报道中国棋手陈耀烨曾在2017年中至2018年末间与国产AI“绝艺”奋战累计2139局。

起初陈耀烨即使执白胜率也在50手就大跌但在长期练习后能做到前50手完全不落下风80手开始才慢慢落后100手之后才被拉开距离。

陈耀烨在2139局的对战中甚至还赢下了两局。

2/2139的胜率与柯洁对AlphaGo Master的1/1176理论胜率接近。

DeepMind的CEO哈萨比斯曾表示绝艺是基于AlphaGo的算法原理开发的并且绝艺也训练了足够长的时间所以两者的实力应当差距不大。

2/2139与1/1176这两个非常接近的数字能够佐证哈萨比斯的判断。

5

让子棋

第三代AlphaGo Master对于人类来说已是不可逾越的高山而DeepMind团队尚且不满足进一步开发了第四代AlphaGo Zero。

而AlphaGo Zero甚至比AlphaGo Master更胜一筹自评等级分达到5185分。可谓巅峰之上更有重楼。

虽然像陈耀烨这样勤勉的棋手仍在坚持平等地挑战强大的人工智能但在更多的场合下人类职业棋手放下了骄傲选择受让子与人工智能对局。

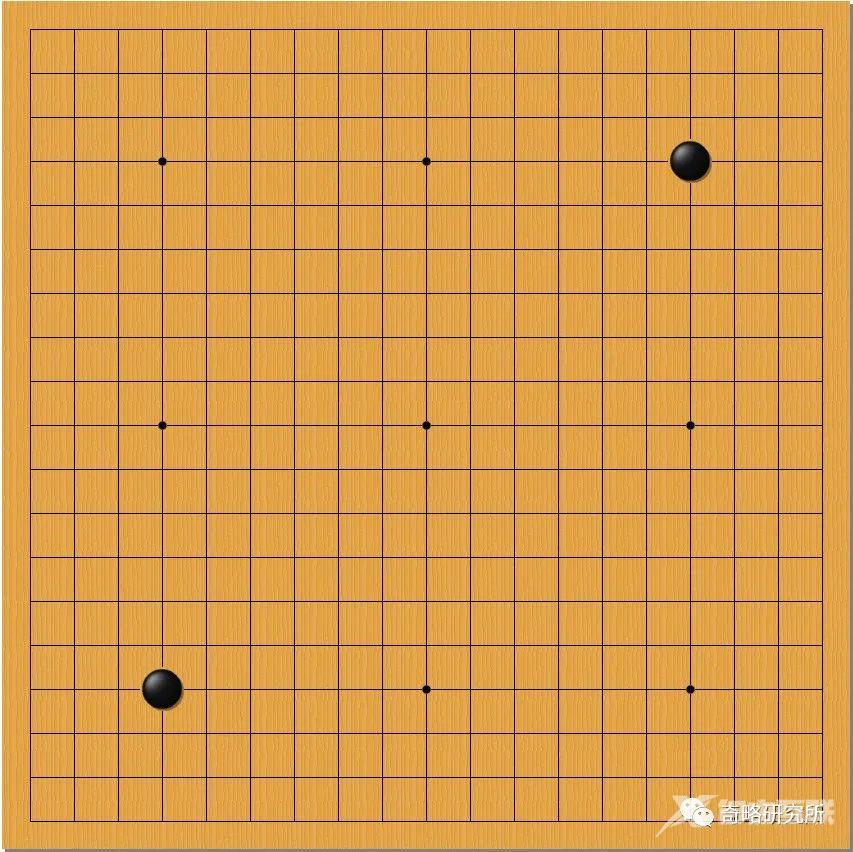

让子是平衡上手与下手差距的一种围棋规则。

以人类棋士常与人工智能下的让二子棋为例人类棋士执黑棋棋局开始之前在棋盘上预置两枚黑子然后轮到白棋先下。

这相当于黑棋开局额外走一步棋。

Figure 5 让二子棋

让二子对于业余爱好者来说不算多即使实力相当的爱好者之间下让二子棋也能互有胜负。

但对于职业棋手来说受让二子是极大的优势。

即使顶尖职业棋手对战职业棋手中实力较弱的让二子也很难获胜。

可以想象像柯洁这样骄傲的天才棋手在发觉自己要被让二子才能与人工智能抗衡之时他的内心是何等挣扎。

在职业棋手常用的野狐对弈平台上人工智能“绝艺”的马甲“绝艺指导A”每天接受职业棋手的挑战规则是绝艺执白让二子黑方贴3又1/4子。

近期绝艺能够赢下大约95%的对局。

Figure 6 绝艺指导A

不过绝艺指导A下的是超快棋规则对人类棋手稍稍不利。

如果拥有更多思考时间人类棋手会表现得更好。

李世乭的退役纪念赛对抗韩国本土AI“韩豆”其中第一、三局李世乭受让二子黑贴3又1/4子第二局分先平等对局。

李世乭第一局受让二子以一记手筋漂亮地擒住韩豆的大龙仅92手就令韩豆认输。

李世乭黑-韩豆白第一局

第二局分先落败后李世乭在第三局再次弈出妙手觅得一锤定音的机会。

可惜随后的一着棋稍缓被韩豆拉长战线之后逐渐逆转局面最终韩豆获胜。

李世乭与韩豆的两盘让二子棋打成一比一平从进程来看双方也是互有机会。

说明让二子黑贴3又1/4子是当下一流棋手与准一流AI之间的合理差距。

如果是最强人类棋手对上最强AI那么差距会进一步增加至约让二子不贴目。

6

结语

1997年国际象棋世界冠军卡斯帕罗夫惜败于超级计算机“深蓝”。

今天国际象棋顶级棋手要受让人工智能一个兵才能勉强逼和之。

而AlphaGo问世之后仅一年多围棋手们也不得不面对受让人工智能二子方可勉强与之抗衡的现实。

其中最大的区别是国际象棋AI可以运行在智能手机上而围棋AI尚需运行在带有高配置显卡的电脑上。

沧桑巨变如今职业棋士们已经习惯把AI当作老师向人工智能学习判断和着法。

不过即使与AI之间的差距已经拉开棋界仍然不乏李世乭、柯洁、陈耀烨这样的勇士坚持不懈地挑战AI。

挑战人工智能并不只是为了寻求那不足千分之一的渺茫胜率更重要的是为了追寻职业棋士共有的人生信条——超越自我。

未来智能实验室的主要工作包括建立AI智能系统智商评测体系开展世界人工智能智商评测开展互联网城市云脑研究计划构建互联网城市云脑技术和企业图谱为提升企业行业与城市的智能水平服务。

如果您对实验室的研究感兴趣欢迎加入未来智能实验室线上平台。扫描以下二维码或点击本文左下角“阅读原文”