篇首语:本文由编程笔记#自由互联小编为大家整理,主要介绍了学会神经风格迁移,免费获取价值百元DIY数字油画定制照片相关的知识,希望对你有一定的参考价值。

学会神经风格迁移免费获取价值百元DIY数字油画定制照片

- 前言

- 神经风格迁移

- 使用VGG提取特征

- 图像加载

- VGG预处理

- 重建内容

- 用Gram矩阵重建风格

- 实现神经风格转换

- 效果展示

- 系列链接

前言

神经风格迁移一经提出便引起了业界的巨大兴趣一些网站允许用户上传照片以进行风格迁移甚至有一些网站将其用于商品销售例如某宝的“DIY数字油画定制照片”等等。但是作为技术宅能用技术完成的怎么能用钱买呢当然是学会神经风格迁移免费获取价值百元DIY数字油画定制照片。

神经风格迁移

图像可以分解为内容和风格内容描述了图像中的构成例如图像中的花草树木风格是指图片的细节例如湖面的纹理和树木的颜色。在一天的不同时间同一建筑的照片具有不同的色调和亮度可以被视为具有相同的内容但风格不同。 在Gatys等人发表的论文中使用CNN将一幅图像的艺术风格转移到另一幅图像

与大多数需要大量训练数据的深度学习模型不同神经风格迁移仅需要两个图像——内容图像和样式图像。可以使用经过训练的CNN例如VGG将风格从风格图像迁移到内容图像上。 如上图所示(A)是内容图像(B)–(D)展示了是风格图像和风格化后的内容图像结果令人惊异有些人甚至使用该算法来创作和出售艺术品。有些网站和应用程序可以上传照片来进行风格迁移而无需了解底层的原理但作为技术人员我们当然希望自己实现此模型。

与大多数需要大量训练数据的深度学习模型不同神经风格迁移仅需要两个图像——内容图像和样式图像。可以使用经过训练的CNN例如VGG将风格从风格图像迁移到内容图像上。 如上图所示(A)是内容图像(B)–(D)展示了是风格图像和风格化后的内容图像结果令人惊异有些人甚至使用该算法来创作和出售艺术品。有些网站和应用程序可以上传照片来进行风格迁移而无需了解底层的原理但作为技术人员我们当然希望自己实现此模型。

使用VGG提取特征

分类器CNN可以分为两部分第一部分称为特征提取器 (feature extractor)主要由卷积层组成后一部分由几个全连接层组成输出类概率得分称为分类器头 (classifier head)。在ImageNet上为分类任务预先训练的CNN也可以用于其他任务这就是所谓的迁移学习 (transfer learning)我们可以转移或重用一些学到的知识到新的网络或应用中。 在CNN中图像重建的两个步骤如下

在正常的网络训练中输入图像是固定的并且使用反向传播的梯度来更新网络权重。在神经风格迁移中所有网络层都被冻结而我们使用梯度来修改输入。在原始的论文使用的是 VGG19 Keras 有一个可以使用的预训练模型。VGG的特征提取器由五个块组成每个块的末尾都有一个下采样。每个块都有24个卷积层整个VGG19具有16个卷积层和3个全连接层。 在下文中我们将实现内容重构同时将其扩展以执行风格迁移。以下是使用预训练的VGG提取block4_conv2的输出层的代码

# 因为我们只需要提取特征所以在实例化VGG模型时使用include_top False冻结网络参数vgg tf.keras.applications.VGG19(include_topFalse, weightsimagenet)content_layers [block4_conv2]content_outputs [vgg.get_layer(x).output for x in content_layers]model Model(vgg.input, content_outputs)

预训练的 Keras CNN 模型分为两部分。底部由卷积层组成通常称为特征提取器而顶部是由全连接层组成的分类器头。因为我们只想提取特征而不关心分类器所以在实例化VGG模型时将设置 include_top False 。

图像加载

首先需要加载内容图像和风格图像

def scale_image(image): MAX_DIM 512 scale np.max(image.shape)/MAX_DIM print(image.shape) new_shape tf.cast(image.shape[:2]/scale, tf.int32) image tf.image.resize(image, new_shape) return imagecontent_image scale_image(np.asarray(Image.open(7.jpg)))style_image scale_image(np.asarray(Image.open(starry-night.jpg)))

VGG预处理

Keras 预训练模型期望输入图像的BGR范围为 [0, 255] 。因此第一步是反转颜色通道以将 RGB 转换为BGR 。 VGG 对不同的颜色通道使用不同的平均值可以使用 tf.keras.applications.vgg19.preprocess_input() 进行预处理在 preprocess_input() 内部分别为BG和R通道的像素值减去 103.939 、116.779 和 123.68 。 以下是前向计算代码在对图像进行前向计算之前先对其进行预处理然后再将其输入模型以返回内容特征。然后我们提取内容特征并将其用作我们的目标

def extract_features(image): image tf.keras.applications.vgg19。preprocess_input(image *255.) content_ref model(image) return content_refcontent_image tf.reverse(content_image, axis[-1])content_ref extract_features(content_image)

在代码中由于图像已标准化为 [0., 1.]因此我们需要通过将其乘以255将其恢复为 [0.255.]。然后创建一个随机初始化的输入该输入也将成为风格化的图像

image tf.Variable(tf.random.normal( shapecontent_image.shape))

接下来我们将使用反向传播从内容特征中重建图像。

重建内容

在训练步骤中我们将图像馈送到冻结的 VGG 中以提取内容特征然后使用 L 2 L_2 L2损失针对目标内容特征进行度量用于计算每个特征层的L2损失

def calc_loss(y_true, y_pred): loss [tf.reduce_sum((x-y)**2) for x, y in zip(y_pred, y_true)] return tf.reduce_mean(loss)

使用 tf.GradientTape() 计算梯度。在正常的神经网络训练中将梯度更新应用于可训练变量即神经网络的权重。但是在神经风格迁移中将梯度应用于图像。之后将图像值剪裁在 [0., 1.] 之间如下所示

for i in range(1,steps1): with tf.GradientTape() as tape: content_features self.extract_features(image) loss calc_loss(content_features, content_ref) grad tape.gradient(loss, image) optimizer.apply_gradients([(grad, image)]) image.assign(tf.clip_by_value(image, 0., 1.))

使用block1_1重建图像训练了2000步后得到重构后的内容图像

使用block4_1重建图像训练了2000步后得到重构后的内容图像

可以看到使用层block4_1时开始丢失细节例如树叶的形状。当我们使用block5_1时我们看到几乎所有细节都消失了并充满了一些随机噪声

可以看到使用层block4_1时开始丢失细节例如树叶的形状。当我们使用block5_1时我们看到几乎所有细节都消失了并充满了一些随机噪声

如果我们仔细观察树叶的结构和边缘仍然得到保留并在其应有的位置。现在我们已经提取了内容提取内容特征后下一步是提取样式特征。

如果我们仔细观察树叶的结构和边缘仍然得到保留并在其应有的位置。现在我们已经提取了内容提取内容特征后下一步是提取样式特征。

用Gram矩阵重建风格

在内容重建中可以看出特征图尤其是前几层既包含风格又包含内容。那么我们如何从图像中提取风格特征呢方法是使用 Gram 矩阵该矩阵可计算不同滤波器响应之间的相关性。假设卷积层1的激活形状为 (H, W, C) 其中 H 和 W 是空间尺寸C 是通道数等于滤波器的数量每个滤波器检测不同的图像特征。 当具有一些共同的特征(例如颜色和边缘)时则认为它们具有相同的纹理。例如如果我们将草地的图像输入到卷积层中则检测垂直线和绿色的滤波器将在其特征图中产生更大的响应。因此我们可以使用特征图之间的相关性来表示图像中的纹理。 要通过形状为 (H, W, C) 的激活来创建Gram矩阵我们首先将其重塑为 C 个向量。每个向量都是大小为 H×W 的一维特征图。对 C 个向量执行点积运算以获得对称的C×C Gram 矩阵。在 TensorFlow 中计算 Gram 矩阵的详细步骤如下

计算 Gram 矩阵的代码如下

def gram_matrix(x): x tf.transpose(tf.squeeze(x), (2,0,1)); x tf.keras.backend.batch_flatten(x) num_points x.shape[-1] gram tf.linalg.matmul(x, tf.transpose(x))/num_points return gram

可以使用此函数为指定的样式层的每个 VGG 层获取 Gram 矩阵。然后我们对来自目标图像和参考图像的 Gram 矩阵使用 L 2 L_2 L2损失。损失函数与内容重建相同。创建 Gram 矩阵列表的代码如下

def extract_features(image): image tf.keras.applications.vgg19.preprocess_input(image *255.) styles self.model(image) styles [self.gram_matrix(s) for s in styles] return styles

以下图像是从不同VGG图层的风格特征中重构得到的

在从block1_1重建的风格图像中内容信息完全消失仅显示高频纹理细节。较高的层block3_1显示了一些卷曲的形状

在从block1_1重建的风格图像中内容信息完全消失仅显示高频纹理细节。较高的层block3_1显示了一些卷曲的形状

这些形状捕获了输入图像中风格的较高层次。 Gram矩阵的损失函数是平方误差之和而不是均方误差。因此层次风格较高的层具有较高的固有权重。这允许传输更高级的风格表示形式例如笔触。如果使用均方误差则低层次的风格特征(例如纹理)将在视觉上更加突出并且可能看起来像高频噪声。

这些形状捕获了输入图像中风格的较高层次。 Gram矩阵的损失函数是平方误差之和而不是均方误差。因此层次风格较高的层具有较高的固有权重。这允许传输更高级的风格表示形式例如笔触。如果使用均方误差则低层次的风格特征(例如纹理)将在视觉上更加突出并且可能看起来像高频噪声。

实现神经风格转换

现在我们可以合并内容和风格重构中的代码以执行神经样式转移。 我们首先创建一个模型该模型提取两个特征块一个用于内容另一个用于样式。内容重建使用block5_conv1层从block1_conv1到block5_conv1的五层用于捕获来自不同层次结构的风格如下所示

vgg tf.keras.applications.VGG19(include_topFalse, weightsimagenet)default_content_layers [block5_conv1]default_style_layers [block1_conv1, block2_conv1, block3_conv1, block4_conv1, block5_conv1]content_layers content_layers if content_layers else default_content_layersstyle_layers style_layers if style_layers else default_style_layersself.content_outputs [vgg.get_layer(x).output for x in content_layers]self.style_outputs [vgg.get_layer(x).output for x in style_layers]self.model Model(vgg.input, [self.content_outputs, self.style_outputs])

在训练循环开始之前我们从各自的图像中提取内容和风格特征以用作目标。虽然我们可以使用随机初始化的输入来进行内容和风格重建但从内容图像开始进行训练会更快

content_ref, _ self.extract_features(content_image)_, style_ref self.extract_features(style_image)

然后我们计算并添加内容和风格损失

def train_step(self, image, content_ref, style_ref): with tf.GradientTape() as tape: content_features, style_features self.extract_features(image) content_loss self.content_weight * self.calc_loss(content_ref, content_features) style_loss self.style_weight*self.calc_loss( style_ref, style_features) loss content_loss style_loss grad tape.gradient(loss, image) self.optimizer.apply_gradients([(grad, image)]) image.assign(tf.clip_by_value(image, 0., 1.)) return content_loss, style_loss

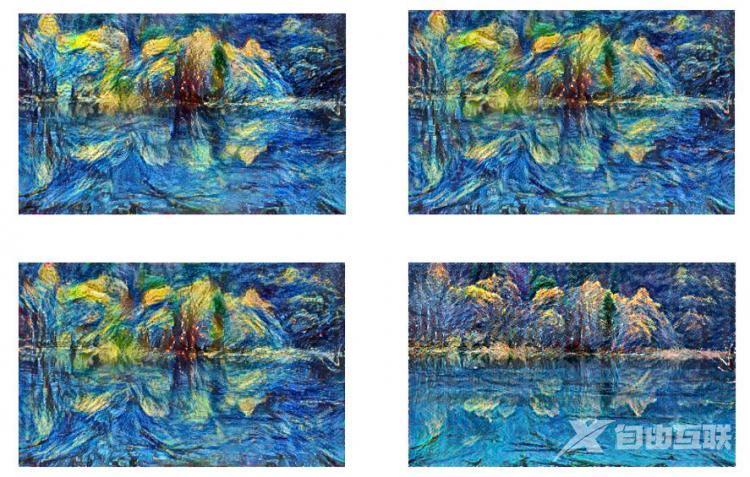

效果展示

以下是使用不同权重和内容层生成的4个风格化图像

可以通过更改权重和层以创建所需的样式。 当然此模型也存在产生一张图片需要几分钟的时间的缺点不能做到实时迁移对于相关改进模型将在之后进行探讨。

可以通过更改权重和层以创建所需的样式。 当然此模型也存在产生一张图片需要几分钟的时间的缺点不能做到实时迁移对于相关改进模型将在之后进行探讨。

系列链接

改进风格迁移重拾《星空》梦 学会CycleGAN进行风格迁移实现自定义滤镜

【感谢龙石为本站提供数据质量管理系统,http://www.longshidata.com/pages/quality.html】