回归分析是一种广泛使用的统计工具,利用已有的实验数据,通过一个方程来定量的描述变量之间的关系,其中的变量可以分为两类

自变量可以有多个,而因变量只有一个,回归的本质就是构建因变量和自变量之间的方程。回归分析有两个经典的用法,第一个就是建模预测,通过构建的回归方程来对新的数据集进行预测,第二个就是用于定量描述变量间的相关性,在GWAS中,就是利用了回归分析的这一用法,本文首先来看下线性回归。

顾名思义,线性回归用线性方程来描述变量之间的关系,根据自变量的个数,又可以划分为一元线性回归和多元线性回归。这里的一元和多元指的就是自变量的个数。以一元线性回归为例,其方程如下

y = ax + b + c

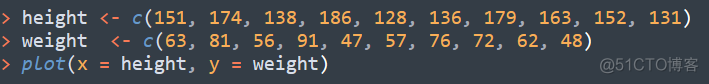

其中x是自变量,y是因变量,a称之为回归系数,b称之为回归常数. c称之为误差,也叫做残差,a和b合称为回归参数,线性回归的目的就是求解回归参数。以探讨身高和体重间的线性关系为例,数据如下

其分布如下所示

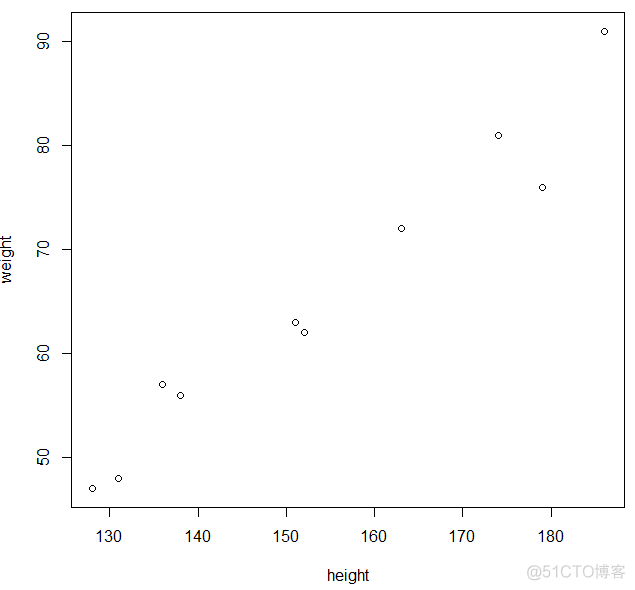

从图上可以直观的感觉到,二者是一个线性关系,线性回归的本质就是根据实际的数据来拟合出一条最佳的直线,这里的最佳非常的重要,对于相同的数据,可以拟合出多条直线,示意如下

图中两条直线的效果看着差不多,那么如何来定量的比较不同直线的拟合效果,从而选择最优的呢?

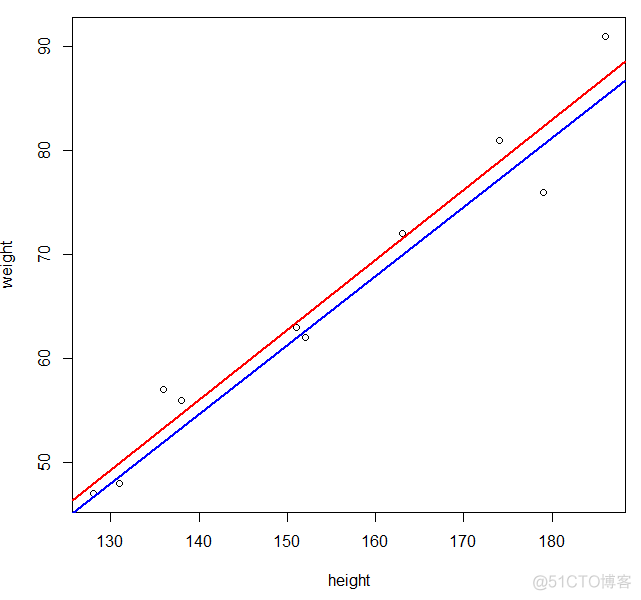

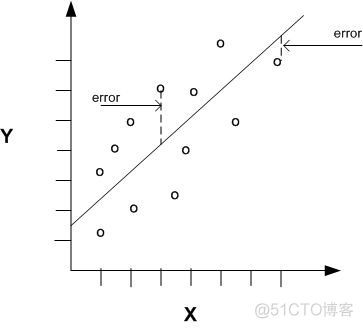

通常有两种方法,第一种称之为最小二乘法,利用实际值和拟合值之间的差值,也就是残差值来构建衡量拟合效果的统计量,图示如下

图中的散点是实际观测值,直线上为拟合值,实际观测值和拟合值之间的线段代表的就是残差。对应的统计量为残差平方和,英文如下

residual sum of squares (RSS)

sum of squared estimate of errors (SSE)

sum of squared residuals (SSR)

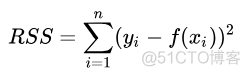

计算公式如下

可以看做是一个欧式距离的求解,最小二乘法将残差平方和最小的直线作为最佳直线。第二种称之为最大似然法,似然其实就是概率,对于拟合出的直线,计算实际观测值出现的概率,将这个概率值作为拟合效果的标记量,概率最大的直线就认为拟合效果最佳。

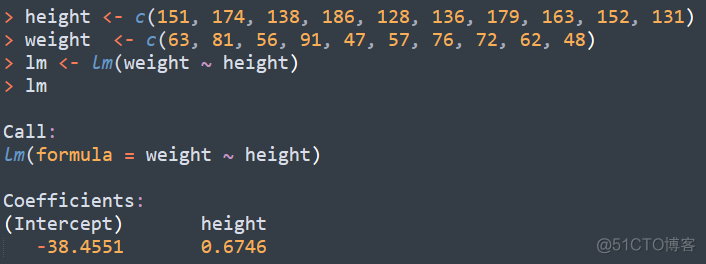

其中,最小二乘法可以看做是最大似然的一个特例,可以由最大似然推导出来,在简单的线性回归中,最小二乘法应用广泛。以R语言为例,进行一元线性回归的代码如下

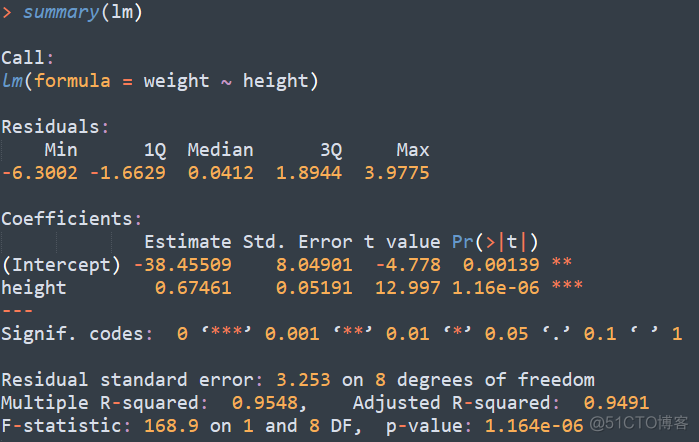

其中intercept称之为截距,对应回归方程中的回归常数,对于height这个自变量,其回归系数为0.6746。这里我们直接得到了最终的回归参数,其实在这里还有很多的细节,通过summary可以进行查看

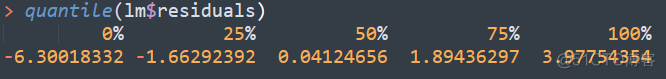

第一个是残差的分布情况,用五个数字来表示,分别是最小值,第一四分位数,中位数,第三四分位数,最大值。在R中,可以通过quantile这个函数来进行计算

第二个是对回归参数的检验,通过t检验来分析回归方程中每个变量和因变量之间的相关性,对应Pr(>|t|)的部分, p值小于0.01认为是相关的。

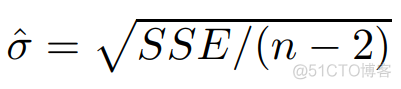

第三个残差标准误,residual standard error, 标准误是衡量总体离散程度的统计量,计算公式如下

残差平方和除以自由度再开根号即可得到残差标准误,所以最佳的拟合直线其对应的残差标准误的值应该也是最小的。

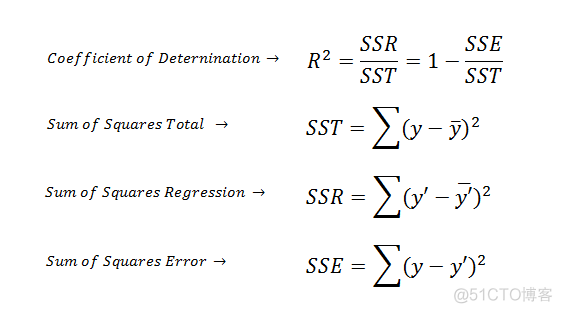

第四个是R2,R-squared, 计算公式如下

SST是实际观测值的方差,SSR是拟合值的方差,R2为拟合值的方差占实际观测值方差的比例,取值范围为0-1。R2也称之为拟合优度,数值越接近1,说明拟合效果越好。对于一个回归方程的解而言,其差标准误和R2值是确定的,对于最佳的拟合直线而言,其残差标准误一定是最小,R2值一定是最大。

R2除了表征拟合效果外,还有一个用途,那就是表征自变量和因变量相关性的大小,只适用于一元线性回归,此时R2的值为自变量x和因变量y的相关系数的平方,所以在单位点的关联分析中,可以根据R2的值筛选相关性强的位点。

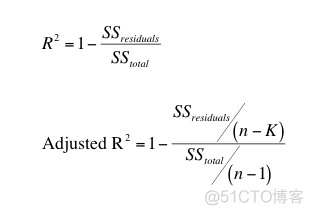

这里还有一个校正之后的R2, 计算公式如下

最后一个是整体方程的显著性检验,通过F检验来判断显著性。在GWAS中,利用线性回归可以分析SNP位点和连续型的表型性状之间的关联,利用pvalue来确定显著关联的位点,进一步可以根据R2来筛选关联性强的snp位点。

·end·